TL;DR : La loi britannique sur la sécurité en ligne de 2023 et la loi européenne sur les services numériques posent désormais un problème. défi sérieux aux entreprises en manque de multicouche vérification de l'âge. Bien que les deux réglementations visent à protéger les enfants de contenus nuisibles et illicites, ils ont tous deux différences clés qui sont essentiels pour que les entreprises puissent maintenir leur conformité.

Les cadres réglementaires régissant les services numériques au Royaume-Uni et dans l'UE convergent vers un principe commun : la protection des utilisateurs des plateformes en ligne, en particulier des enfants. Ces deux lois numériques protègent les enfants et les adultes en ligne, soulignant l'importance de la sécurité des utilisateurs pour tous les groupes d'âge.

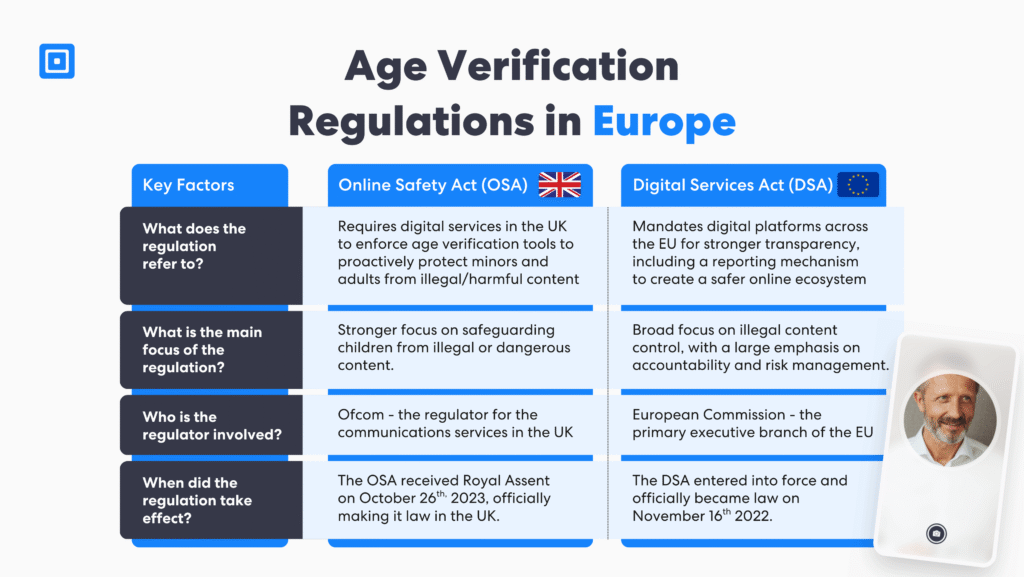

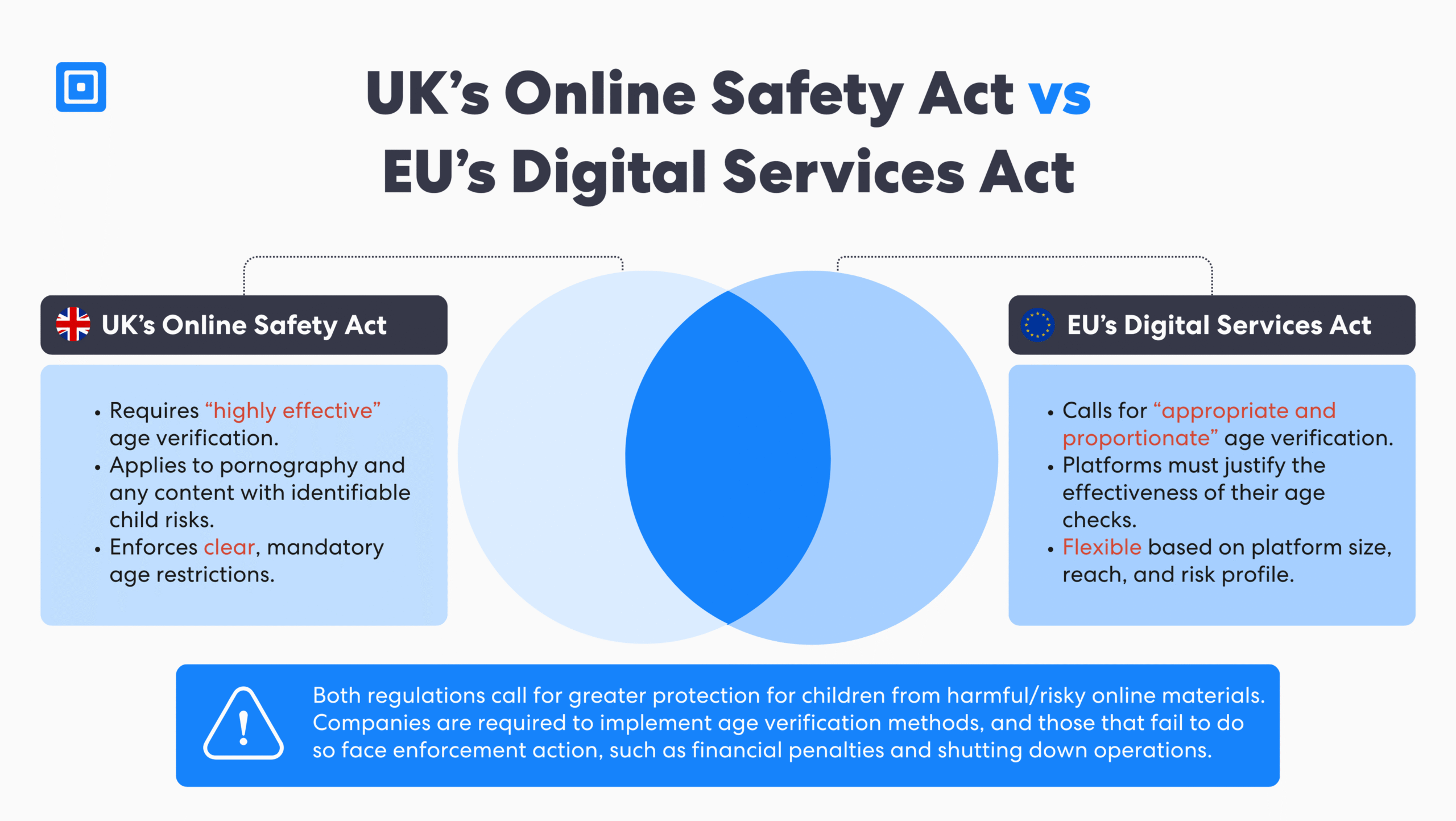

La loi britannique sur la sécurité en ligne de 2023 (OSA) et la loi européenne sur les services numériques (DSA) imposent des obligations cruciales en matière de vérification de l'âge et de sécurité. Cependant, leurs approches varient selon les plateformes numériques. Comprendre ces différences est essentiel pour une confiance durable. Cet article compare l'OSA et la DSA en termes de vérification de l'âge, de responsabilité des plateformes, de sanctions et de gouvernance, et met en évidence les mesures que les entreprises technologiques doivent prendre pour se conformer aux deux lois.

Comment chaque loi protège les utilisateurs

Avec l'évolution rapide des marchés numériques, il devient de plus en plus nécessaire de protéger les utilisateurs contre les contenus préjudiciables et les activités illégales en ligne. Loi sur la sécurité en ligne et le Loi sur les services numériques sont deux réglementations historiques conçues pour créer de nouvelles règles et un environnement plus sûr sur les plateformes, les médias sociaux et les services numériques qui permettent aux utilisateurs de publier du contenu en ligne.

le OSA La loi met l'accent sur la protection des droits fondamentaux des enfants. En exigeant des plateformes en ligne qu'elles luttent proactivement contre les activités préjudiciables et en mettant en place des outils de vérification de l'âge, elle donne la priorité à la suppression des contenus illégaux et offre aux utilisateurs un plus grand contrôle sur les contenus auxquels ils accèdent. Elle introduit également des poursuites pénales pour lutter contre les abus et les pratiques dangereuses en ligne.

En revanche, la DSA concerne toutes les plateformes en ligne opérant au sein de l'Union européenne, y compris les très grandes plateformes en ligne (TGE) et les grands moteurs de recherche. La DSA fixe des règles pour ces plateformes numériques, les obligeant à publier des rapports annuels contenant des informations sur la sécurité en ligne. Elles doivent divulguer le fonctionnement de leurs algorithmes et fournir des explications sur les décisions de suppression de contenu.

En exigeant des plateformes un contrôle plus strict de la publicité ciblée et en les obligeant à prendre des mesures contre les contenus illicites, elles ciblent les plateformes en ligne qui mettent en avant des abus sexuels sur mineurs, des images intimes abusives et l'usage de substances nocives. L'OSA et la DSA exigent toutes deux des plateformes qu'elles prennent des mesures proactives pour protéger les utilisateurs et prévenir la diffusion de contenus illicites.

L'estimation de l'âge, la vérification et la vérification par couches ne sont plus facultatives. Ce sont des mesures de protection essentielles pour les plateformes qui hébergent du contenu généré par les utilisateurs, des jeux ou des interactions sociales. – Harry Varatharasan, Responsable de la conformité des produits.

Les services de médias sociaux et les plateformes de partage de vidéos, ainsi que les forums, le stockage cloud de fichiers grand public et les sites de partage sont concernés par ces réglementations. Elles visent à garantir que les entreprises interviennent rapidement pour supprimer les contenus dangereux tels que la pornographie en ligne, les drogues illicites et les contenus incitant à l'automutilation, afin de permettre aux utilisateurs de mieux contrôler leur expérience en ligne.

Portée et compétence des lois

La loi sur la sécurité en ligne et la loi sur les services numériques abordent la réglementation différemment. sécurité en ligne et vérification de l'âgeCes deux critères s'appliquent aux services de messagerie instantanée en ligne, aux réseaux sociaux et aux forums en ligne qui permettent la création de contenu par les utilisateurs, quelle que soit la localisation géographique du fournisseur. Le critère clé réside dans le fait que le service cible les utilisateurs du Royaume-Uni ou de l'Union européenne.

Les entreprises exploitant des services numériques peuvent être soumises aux deux cadres réglementaires, même si elles sont basées hors de ces régions. Les services concernés comprennent un nombre important de services de recherche, de plateformes de médias sociaux, de services de partage de vidéos, d'outils de partage de fichiers, de messagerie et de forums en ligne, de services de rencontres, de moteurs de recherche et de fournisseurs d'hébergement cloud.

Alors que l'OSA applique un modèle de conformité basé sur des règles et centré sur le Royaume-Uni, la DSA adopte une approche à plusieurs niveaux, Approche fondée sur le risque Adapté à l'échelle et aux fonctionnalités de la plateforme. Malgré ces différences, les deux cadres s'appliquent aux services numériques qui autorisent le contenu utilisateur au Royaume-Uni ou dans l'UE, ou qui ciblent ces pays. Par conséquent, la conformité est requise quel que soit le siège social de l'entreprise.

Obligations de vérification de l'âge pour les plateformes en ligne

La loi sur la sécurité en ligne de 2023 (OSA) exige que les plateformes mettent en œuvre des mesures « hautement efficaces » mécanismes de vérification de l'âge, notamment pour la pornographie et les contenus susceptibles de nuire aux mineurs. Cette obligation s'étend aux contenus légaux lorsqu'ils présentent des risques identifiables pour les enfants. La Loi sur les services aux mineurs impose aux plateformes d'établir et d'appliquer des restrictions d'âge claires afin d'empêcher l'accès des mineurs.

Les méthodes de vérification approuvées comprennent la vérification des pièces d'identité officielles, l'authentification biométrique, l'estimation de l'âge par reconnaissance faciale grâce à l'IA et les systèmes résistants aux tactiques de contournement telles que l'utilisation de VPN. Par exemple, si un utilisateur tente de masquer sa localisation via un VPN, ComplyCube peut détecter et signaler la session, déclenchant ainsi une alerte. vérification de l'âge.

En revanche, la loi sur les services numériques (DSA) exige «approprié et proportionné” des mesures, offrant plus de flexibilité en fonction de la taille, de la portée et du profil de risque de la plateforme. Bien que moins prescriptive que l'OSA, la DSA oblige néanmoins les plateformes à démontrer l'efficacité de leurs processus de vérification de l'âge, notamment lorsque des mineurs peuvent être exposés à des contenus préjudiciables.

L'application réglementaire de la DSA exige une justification claire de la mise en œuvre concrète des mesures de protection. Malgré leurs différences, les deux lois partagent un objectif commun : protéger les enfants en ligne grâce à des limites d'âge applicables et à des normes de responsabilité claires. Pour en savoir plus sur la fraude à l'identité au Royaume-Uni, cliquez ici : Le prix de la fraude à l’identité au Royaume-Uni.

Obligations de transparence et de déclaration

La loi sur la sécurité en ligne de 2023 (OSA) et la loi sur les services numériques (DSA) exigent toutes deux que les plateformes publient des rapports annuels de transparence, le premier étant attendu d'ici juillet 2025. Ces rapports doivent couvrir les demandes de retrait, les mesures de modération, les méthodes de vérification de l'âge et les efforts plus larges d'atténuation des risques.

Alors que la DSA se concentre sur la réduction des risques systémiques grâce à des obligations flexibles et fondées sur les risques, l'OSA impose une conformité opérationnelle plus stricte, alignée sur Approuvé par l'Ofcom normes. Ensemble, ces lois visent à renforcer la responsabilisation et à garantir la sécurité des enfants sur les plateformes numériques grâce à des divulgations régulières et vérifiables.

Contenu illégal et responsabilité de la plateforme

L'OSA exige des plateformes qu'elles luttent proactivement contre les contenus illicites et préjudiciables, en leur imposant des obligations spécifiques pour prévenir les atteintes à l'intégrité physique. La réglementation prévoit des amendes pouvant atteindre 101 TP6T de chiffre d'affaires mondial, des ordonnances de blocage en cas de violations répétées, une priorité donnée à la sécurité des enfants en réduisant les contenus à caractère autodestructeur et pédopornographique, et en encourageant ou en favorisant les actes d'automutilation graves.

Elle met en évidence ce qui est désormais considéré comme un contenu illégal et une infraction pénale. Des mesures d'application sont déclenchées en cas de risque matériel de préjudice grave pour les utilisateurs britanniques. La réglementation DSA prévoit des amendes pouvant aller jusqu'à 6% de chiffre d'affaires mondial, nécessite une gestion par les autorités nationales sous la supervision de la CE, et se concentre sur les très grandes plateformes en ligne (VLOP) et la responsabilité algorithmique.

Étude de cas : TikTok soumis à la loi DSA (2024)

Aperçu

En février 2024, la Commission européenne a ouvert une enquête sur TikTok pour suspicion de violation de la loi sur les services numériques (DSA). L'enquête a ciblé des domaines clés, notamment la protection de l'enfance, la transparence publicitaire, l'accès aux données algorithmiques et la gestion des risques liés à la conception potentiellement addictive de la plateforme.

Une attention particulière a été portée à l'efficacité des systèmes de vérification de l'âge de TikTok et à leur capacité à protéger les mineurs contre les contenus dangereux. La structure de la plateforme et sa contribution aux comportements addictifs des utilisateurs ont également été étudiées.

Actions et réponses

L'enquête de la Commission européenne sur TikTok s'est concentrée sur trois points essentiels : les mécanismes de sécurité des enfants, la transparence des pratiques publicitaires et les politiques d'accès aux données de la plateforme. L'enquête portait principalement sur la conception algorithmique des systèmes de TikTok et leur rôle potentiel dans la promotion de comportements préjudiciables, notamment chez les mineurs.

Résolution

En août 2024, la Commission de l'Union européenne a publié un communiqué de presse indiquant que TikTok acceptait supprimer la fonctionnalité de récompenses « TikTok Lite »Cette fonctionnalité avait été critiquée pour sa conception addictive, qui affectait l'expérience utilisateur des enfants. Cette affaire souligne que l'application de la DSA n'est pas purement réactive. Les régulateurs façonnent désormais la conception des plateformes et protègent les droits fondamentaux, notamment dans des domaines critiques comme l'engagement des jeunes et les risques algorithmiques.

Contrôles de la publicité et du profilage du contenu pour les enfants en ligne

La loi sur les services numériques (DSA) interdit explicitement le ciblage comportemental des mineurs, notamment la publicité basée sur le profilage et l'utilisation d'interfaces utilisateur à motifs cachés dans les systèmes de recommandation de contenu. Ces nouvelles règles visent à réduire les pratiques manipulatrices qui affectent de manière disproportionnée les enfants sur Internet.

Bien que la loi de 2023 sur la sécurité en ligne (OSA) ne régisse pas directement le ciblage publicitaire, elle impose de nouvelles obligations pour empêcher les enfants d'être confrontés à des contenus commerciaux préjudiciables, notamment sur les moteurs de recherche. Ensemble, ces cadres témoignent d'un durcissement de la réglementation concernant la responsabilité des plateformes numériques envers les jeunes utilisateurs.

Plus de contrôle grâce aux normes de mise en œuvre techniques et éthiques

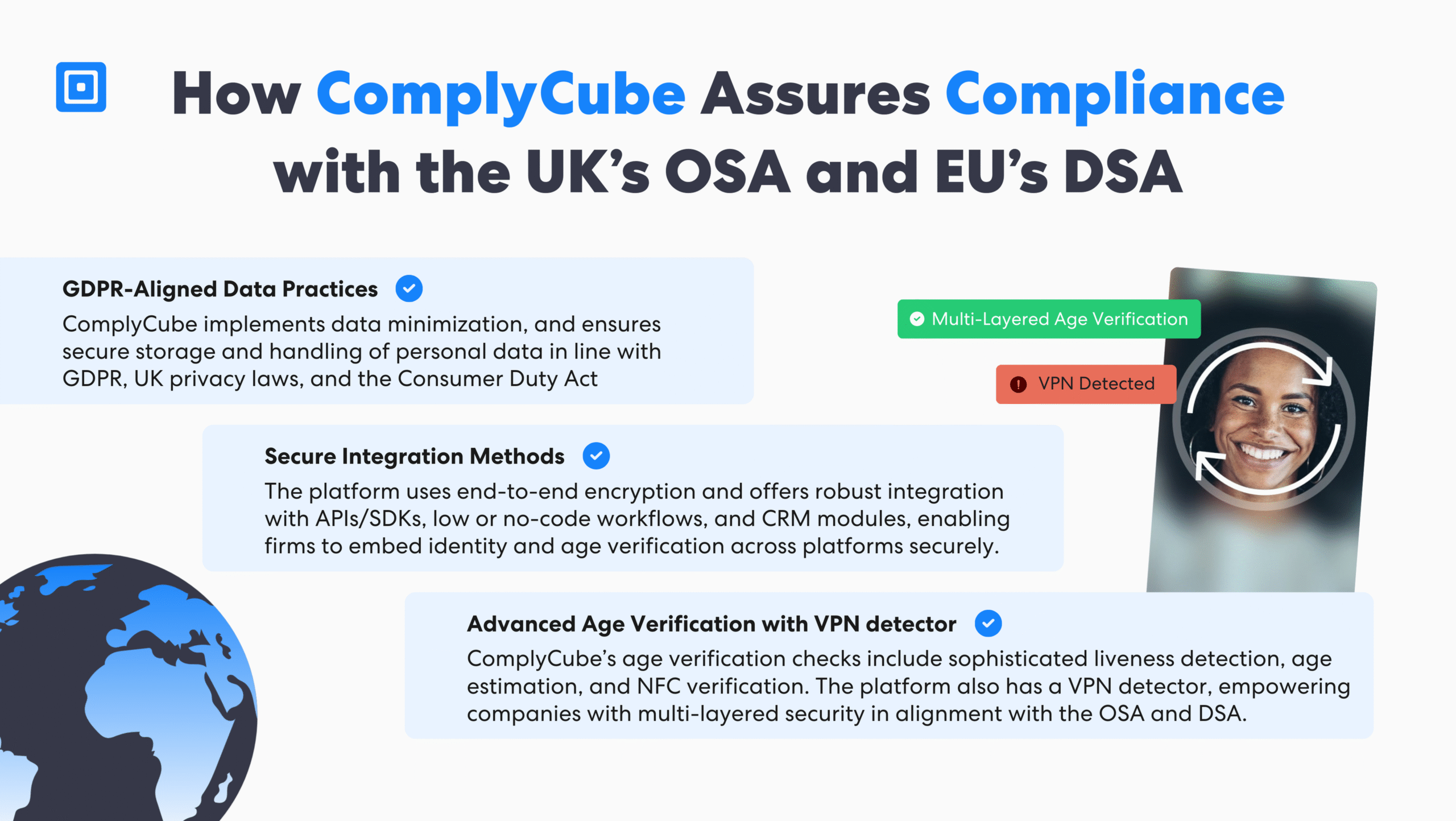

Pour se conformer à la loi de 2023 sur la sécurité en ligne (OSA) et à la loi sur les services numériques (DSA), les plateformes sont tenues de minimiser la collecte de données conformément au RGPD, d'éviter de stocker des informations sensibles liées à l'âge et de garantir la transparence de leurs processus de vérification de l'âge. Elles doivent également mettre en place des mesures de protection contre les risques de réidentification et utiliser des méthodes d'intégration sécurisées, telles que SDK ou des modules sans code.

La plateforme ComplyCube prend en charge ces exigences grâce à la vérification sur l'appareil, à la détection biométrique de la vivacité, Lecture de la puce NFCet la reconnaissance multi-appareils, offrant à la fois une conformité prescriptive et une mise en œuvre adaptable à grande échelle.

Gouvernance, atténuation des risques et responsabilité des dirigeants

En vertu de la loi de 2023 sur la sécurité en ligne (OSA) et de la loi sur les services numériques (DSA), les plateformes sont tenues de procéder à des évaluations régulières des risques et d'atténuer activement tout risque matériel pour les utilisateurs, en particulier les enfants. Ces évaluations doivent tenir compte de l'exposition à des contenus tels que la pornographie, l'automutilation ou les troubles alimentaires, ainsi que des risques d'abus systémiques découlant des contenus générés par les utilisateurs.

De plus, les plateformes doivent évaluer l'impact de leurs systèmes de publicité et de recommandation sur les mineurs. L'OSA exige la nomination de responsables de la conformité et la tenue de registres prêts à être audités, tandis que la DSA impose des politiques rigoureuses de gouvernance du contenu et des audits internes pour les très grandes plateformes en ligne (TLE).

Impact sur les PME et les plateformes de niche

Il existe une idée fausse répandue selon laquelle les petites plateformes sont exemptées des obligations réglementaires. En réalité, la loi de 2023 sur la sécurité en ligne (OSA) s'applique en fonction de la nature du risque et de l'accessibilité du contenu, et non de la taille de la plateforme. Si la loi sur les services numériques (DSA) accorde un allègement procédural aux petites et moyennes entreprises (PME) de moins de 50 salariés ou dont le chiffre d'affaires annuel est inférieur à 10 millions d'euros, elle ne dispense pas de leurs responsabilités fondamentales. Toutes les plateformes, quelle que soit leur taille, sont tenues de mettre en œuvre des mesures de sécurité proportionnées si leurs services sont susceptibles d'être consultés par des enfants.

Intégration avec d'autres nouvelles règles

Les exigences en matière de vérification de l'âge recoupent plusieurs cadres réglementaires clés. Règlement Général sur la Protection des Données (RGPD)Les plateformes doivent garantir la minimisation des données, établir une base légale pour le traitement et appliquer les principes de protection de la vie privée dès la conception. Le règlement eIDAS établit des normes d'assurance de l'identité numérique, particulièrement pertinentes pour les vérifications au sein de l'UE.

De plus, le Loi sur les marchés numériques soumet les plateformes de contrôle d'accès à un examen minutieux de leur conception, y compris les considérations liées à l'âge. La législation secondaire de l'OSA et de la DSA fournit les seuils et classifications détaillés nécessaires à la mise en œuvre de ces obligations pour les différents prestataires de services.

L'Ofcom enquête sur 34 sites Web pornographiques pour non-vérification de l'âge

Enquête sur le contenu prioritaire principal

Le 31 juillet 2025, l'Ofcom a lancé des enquêtes formelles contre quatre fournisseurs de services numériques exploitant au total 34 sites web pornographiques. Ces plateformes étaient soupçonnées d'avoir enfreint les exigences de l'OSA en ne mettant pas en œuvre les nouvelles règles. L'enquête de l'Ofcom a porté sur la question de savoir si les plateformes avaient adopté des systèmes de vérification de l'âge conformes à la norme légale de « hautement efficace ».

Sanctions potentielles en cas de non-conformité

Les résultats de ces enquêtes pourraient créer des précédents importants pour la réglementation future des plateformes similaires. Ces sanctions peuvent atteindre 18 millions de livres sterling ou 101 TP6T du chiffre d'affaires mondial admissible d'une plateforme, selon le montant le plus élevé. Dans les cas extrêmes, l'Ofcom peut également ordonner aux fournisseurs d'accès à Internet de bloquer l'accès aux plateformes contrevenantes au Royaume-Uni.

Résultats et impacts

Bien que les décisions finales des enquêtes en cours soient toujours en attente, les premières données suggèrent que l'application de la loi OSA a déjà un impact mesurable. Les principales plateformes de contenu pour adultes ont enregistré une baisse substantielle de leur trafic, un rapport faisant état d'une baisse de 47% du nombre de visites au Royaume-Uni suite à la mise en œuvre de la nouvelle règle. Cette forte baisse témoigne de l'adoption active de systèmes de vérification de l'âge, volontairement ou sous la pression réglementaire.

Adopter une stratégie de conformité unifiée

Pour se conformer à la fois à l'OSA et à la DSA, les entreprises doivent adopter une stratégie de conformité globale. Elles doivent investir dans des solutions dynamiques de gestion des risques capables de déclencher des flux de travail automatisés en fonction de la géolocalisation des utilisateurs ou du type de document.

La rationalisation des cycles de test et d’itération devient plus efficace en s’associant à un fournisseur de vérification d'âge Avec des SDK et des API pour une intégration fluide. De plus, la surveillance de l'évolution des codes de bonnes pratiques permet aux organisations de mieux maîtriser l'évolution des réglementations. Pour en savoir plus, cliquez ici : Que sont les solutions de vérification d’identité ?

Points clés à retenir

- La loi sur la sécurité en ligne impose des contrôles d'âge stricts et des protocoles de sécurité pour protéger les enfants des contenus illégaux et préjudiciables.

- La loi européenne sur les services numériques applique une approche proportionnée et basée sur le risque, adaptée à la plateforme et au profil du public cible.

- L'OSA du Royaume-Uni et le DSA de l'UE confère aux entreprises une plus grande responsabilité dans la régulation du contenu au moyen d’évaluations des risques transparentes et détaillées.

- Les plateformes doivent adopter une assurance éthique de l'âge qui reconnaissent les droits fondamentaux, la conception préservant la confidentialité et les outils de conformité unifiés.

- Services de petite taille, y compris les startups, ne sont pas exemptés de l’examen en vertu de l’OSA et de la DSA si les enfants peuvent toujours accéder à leur contenu et le consommer.

Renforcer la conformité aux réglementations sur la vérification de l'âge dans le monde entier

La convergence de la loi de 2023 sur la sécurité en ligne (OSA) et de la loi sur les services numériques (DSA) reflète une évolution de la responsabilité numérique. Les plateformes doivent dépasser la modération réactive et adopter des principes de sécurité dès la conception, notamment pour les enfants. Les entreprises qui adoptent des pratiques de sécurité ouvertes et axées sur l'utilisateur gagneront la confiance et la bienveillance réglementaire dans un contexte de conformité en pleine évolution.

Explorez des solutions transparentes et sur mesure solutions d'assurance âge multicouches sur la plateforme ComplyCube. Intégrez vos clients en quelques secondes et évitez les lourdes sanctions prévues par la loi sur la sécurité en ligne et la loi sur les services numériques. Parlez à un membre du ComplyCube équipe aujourd'hui.

Questions fréquemment posées

L’OSA et le DSA s’appliquent-ils aux plateformes dont le public est majoritairement adulte ?

Oui. Même si une plateforme cible principalement les adultes, elle doit se conformer si des mineurs peuvent accéder au service ou si du contenu préjudiciable ou illégal est disponible. Les plateformes sont également tenues de fournir des outils de filtrage et de contrôle parental pour limiter l'exposition des enfants.

Qu’est-ce qui est considéré comme contenu prioritaire en vertu de la loi sur la sécurité en ligne (OSA) ?

Le contenu prioritaire comprend la pornographie, ainsi que les contenus faisant la promotion des troubles alimentaires, de l'automutilation ou du suicide. Ceci s'applique même si le contenu est légal, car il est considéré comme dangereux pour les enfants.

Quel est l’impact de l’OSA ou du DSA sur la vérification de l’âge sur les plateformes de médias sociaux ?

En vertu de la loi OSA, la vérification de l'âge est obligatoire si des enfants sont susceptibles d'accéder à la plateforme. La loi DSA de l'UE exige également une vérification de l'âge lorsque le contenu présente des risques, ce qui signifie que la plupart des plateformes de médias sociaux grand public doivent adopter des mesures de vérification de l'âge.

Les entreprises ou les dirigeants peuvent-ils faire l’objet de sanctions pénales en vertu de ces lois ?

La loi OSA prévoit que les cadres dirigeants sont passibles de poursuites pénales si les plateformes ne respectent pas leurs obligations en matière de sécurité et de vérification de l'âge. La loi DSA prévoit également des sanctions, y compris pénales, selon la manière dont chaque État membre de l'UE met en œuvre le règlement.

Comment l’OSA et la DSA protègent-elles les droits fondamentaux tout en assurant la conformité ?

Les deux lois prévoient des garanties pour équilibrer la réglementation et les droits des utilisateurs. Elles exigent des plateformes qu'elles respectent la liberté d'expression et la vie privée, tout en appliquant des obligations proportionnées de vérification de l'âge, de modération des contenus et de signalement.