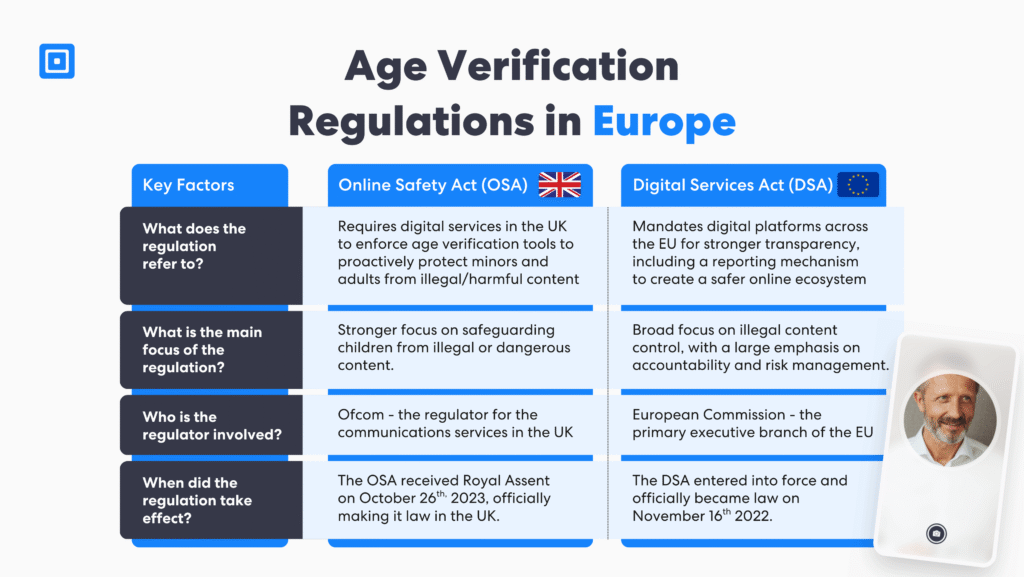

Kurz gesagt: Der britische Online Safety Act 2023 und der Digital Services Act der EU stellen nun eine ernsthafte Herausforderung für Unternehmen mit einem Mangel an vielschichtig Altersüberprüfungen. Während die Einhaltung des Digital Service Act und des Online Safety Act darauf abzielt, Kinder schützen vor schädlichen und illegalen Inhalten, sie haben beide Hauptunterschiede die für Unternehmen von entscheidender Bedeutung sind, um die Compliance aufrechtzuerhalten.

Wie der Online Safety Act und der Digital Safety Act Benutzer schützen

Mit der rasanten Entwicklung der digitalen Märkte wächst die Notwendigkeit, Nutzer vor schädlichen Inhalten und illegalen Online-Aktivitäten zu schützen. Der Online Safety Act 2023 und die Gesetz über digitale Dienste sind zwei wegweisende Vorschriften, die neue Regeln und eine sicherere Umgebung für Plattformen, soziale Medien und digitale Dienste schaffen sollen, die es Benutzern ermöglichen, Inhalte online zu veröffentlichen.

Der OSA Der Schutz der Grundrechte von Kindern steht im Vordergrund. Online-Plattformen müssen proaktiv gegen schädliche Aktivitäten vorgehen und Altersverifizierungstools implementieren. Die Einhaltung des Online Safety Act legt den Schwerpunkt auf die Entfernung illegaler Inhalte und gibt Nutzern mehr Kontrolle über die Inhalte, auf die sie stoßen. Darüber hinaus werden strafrechtliche Maßnahmen gegen Online-Missbrauch und gefährliche Machenschaften eingeführt.

Im Gegensatz dazu betrifft der DSA alle Online-Plattformen innerhalb der Europäischen Union, einschließlich sehr großer Online-Plattformen (VLOPs) und großer Online-Suchmaschinen. Der DSA legt Regeln für diese digitalen Plattformen fest und verpflichtet sie, jährliche Berichte mit Informationen zur Online-Sicherheit zu veröffentlichen. Sie müssen offenlegen, wie ihre Algorithmen funktionieren, und Begründungen für Entscheidungen zur Entfernung von Inhalten liefern.

Indem sie Plattformen zu strengeren Kontrollen zielgerichteter Werbung und zum Vorgehen gegen illegale Inhalte verpflichten, zielen sie auf Online-Plattformen ab, die sexuellen Kindesmissbrauch, Missbrauch intimer Bilder und den Konsum schädlicher Substanzen zeigen. Sowohl das OSA als auch das DSA verpflichten Plattformen, proaktive Maßnahmen zum Schutz der Nutzer zu ergreifen und die Verbreitung illegaler Inhalte zu verhindern.

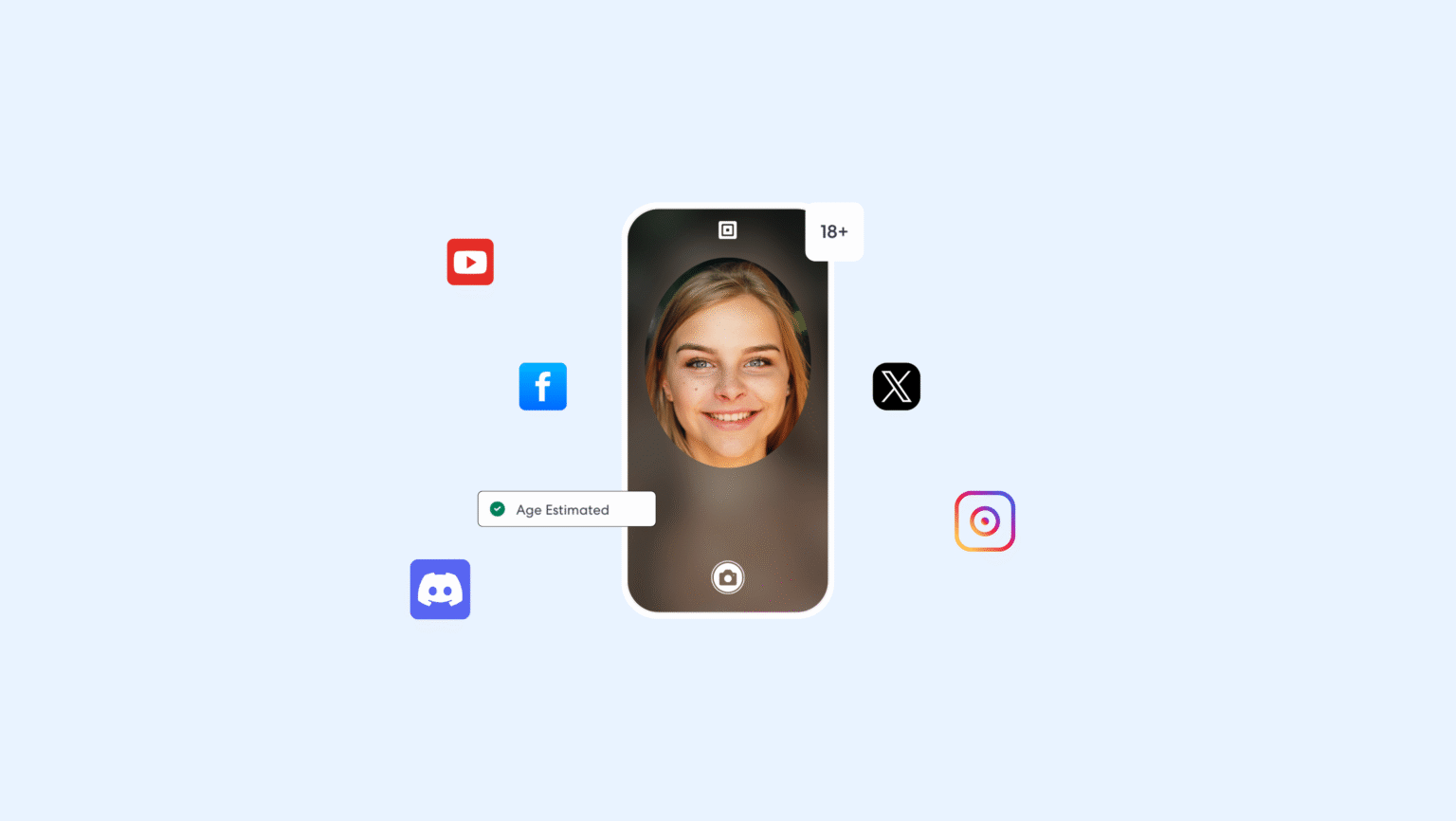

Altersschätzung, -prüfung und mehrstufige Verifizierung sind nicht länger optional.

Von diesen Regelungen sind sowohl Social-Media-Dienste und Video-Sharing-Plattformen als auch Foren, Cloud-Speicher für private Dateien und Sharing-Sites betroffen. Sie sollen Unternehmen dazu bewegen, unsichere Inhalte wie Online-Pornografie, illegale Drogen und selbstverletzendes Material schnell zu entfernen, um Nutzern mehr Kontrolle über ihr Online-Erlebnis zu geben.

Geltungsbereich und Zuständigkeit des Online Safety Act 2023 und des Digital Services Act

Der Online Safety Act und der Digital Services Act gehen unterschiedlich an die Regulierung heran. Online-Sicherheit und AltersverifizierungBeides gilt für Online-Instant-Messaging-Dienste, Social-Media-Unternehmen und Online-Foren, die nutzergenerierte Inhalte ermöglichen, unabhängig vom geografischen Standort des Anbieters. Der entscheidende Faktor liegt darin, dass der Zielmarkt des Dienstes Nutzer im Vereinigten Königreich oder in der Europäischen Union sind.

Unternehmen, die digitale Dienste anbieten, unterliegen möglicherweise beiden Regulierungsrahmen, auch wenn sie ihren Sitz außerhalb dieser Regionen haben. Zu den abgedeckten Diensten gehören eine beträchtliche Anzahl von Suchdiensten, Social-Media-Plattformen, Video-Sharing-Diensten, Filesharing-Tools, Online-Messaging und -Foren, Dating-Dienste, Suchmaschinen und Cloud-Hosting-Anbieter.

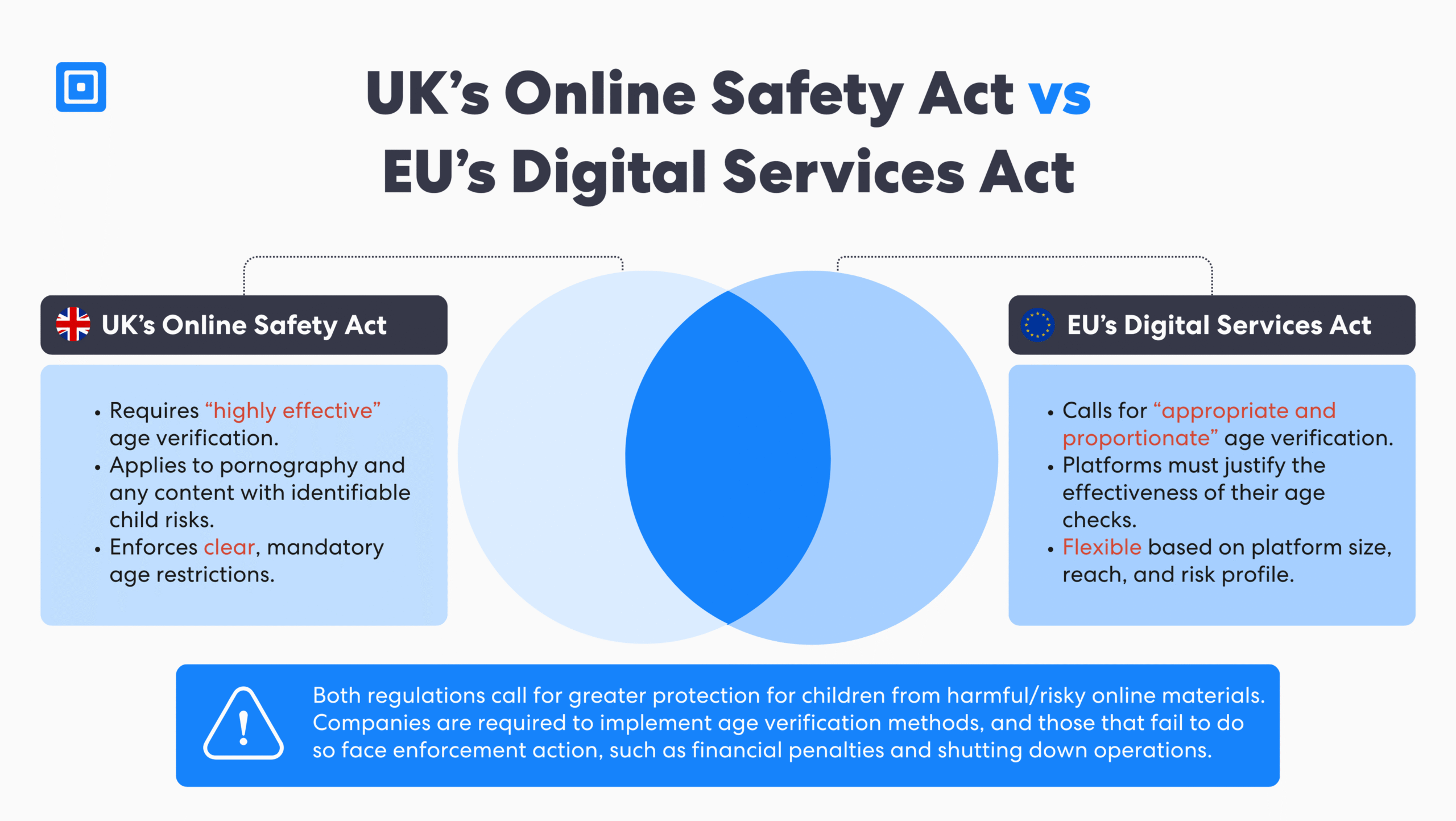

Während das OSA ein auf Großbritannien ausgerichtetes, regelbasiertes Compliance-Modell durchsetzt, verfolgt das DSA einen mehrschichtigen, risikobasierter Ansatz Maßgeschneidert für Plattformgröße und -funktion. Trotz dieser Unterschiede gelten beide Rahmenwerke für digitale Dienste, die Nutzerinhalte innerhalb Großbritanniens oder der EU zulassen oder auf diese ausgerichtet sind. Daher ist die Einhaltung unabhängig vom Unternehmenssitz erforderlich.

Altersüberprüfungspflichten für Online-Plattformen mit dem Online Safety Act 2023 und dem Digital Services Act

Der Online Safety Act 2023 (OSA) verlangt von Plattformen die Umsetzung „hochwirksamer“ Mechanismen zur Altersüberprüfung, insbesondere für Pornografie und Inhalte, die Minderjährigen schaden könnten. Diese Verpflichtung erstreckt sich auch auf legale Inhalte, wenn diese erkennbare Risiken für Kinder bergen. Das OSA schreibt vor, dass Plattformen klare Altersbeschränkungen festlegen und durchsetzen müssen, um den Zugriff Minderjähriger zu verhindern.

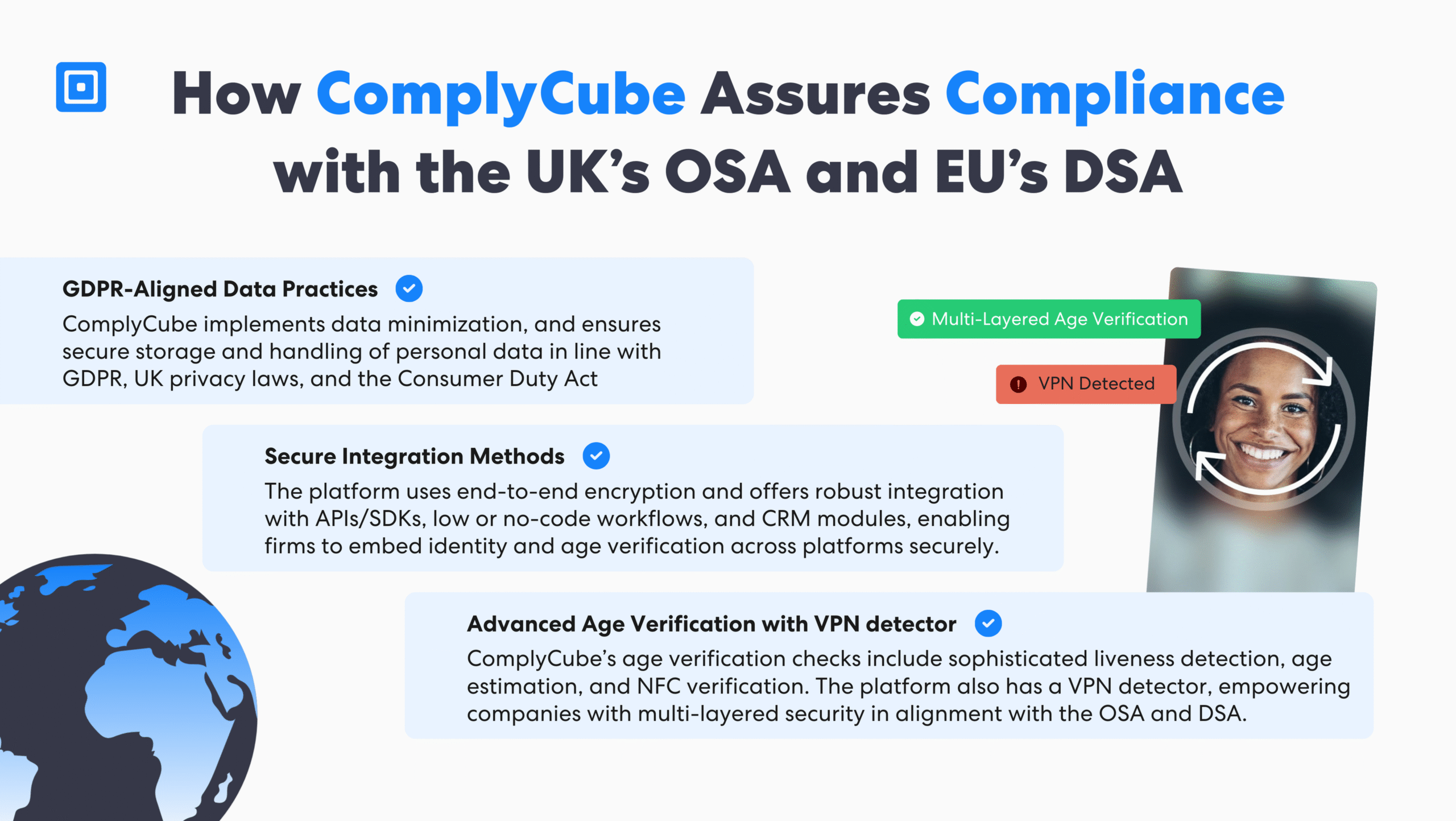

Zu den zugelassenen Verifizierungsmethoden gehören die Überprüfung von amtlichen Ausweisen, biometrische Authentifizierung, KI-gestützte Gesichtsaltersbestimmung und Systeme, die gegen Umgehungstaktiken wie die Nutzung von VPN resistent sind. Versucht ein Benutzer beispielsweise, seinen Standort über ein VPN zu verbergen, kann ComplyCube die Sitzung erkennen und kennzeichnen, woraufhin eine biometrische Authentifizierungsprüfung, wodurch der Benutzer nicht fortfahren kann, bis er sein Alter bestätigt hat.

Im Gegensatz dazu fordert der Digital Services Act (DSA) „angemessen und verhältnismäßig”-Maßnahmen, die je nach Größe, Reichweite und Risikoprofil der Plattform mehr Flexibilität bieten. Obwohl der DSA weniger verbindlich ist als der OSA, verpflichtet er Plattformen dennoch dazu, die Wirksamkeit ihrer Altersüberprüfungsprozesse nachzuweisen, insbesondere wenn Minderjährige schädlichen Inhalten ausgesetzt sein könnten.

Die Durchsetzung der Vorschriften im Rahmen des DSA erfordert eine klare Begründung der praktischen Anwendung der Schutzmaßnahmen. Trotz ihrer Unterschiede verfolgen beide Gesetze ein gemeinsames Ziel: den Schutz von Kindern im Internet durch durchsetzbare Altersgrenzen und klare Verantwortlichkeitsstandards. Erfahren Sie hier mehr über Identitätsbetrug in Großbritannien: Der Preis des Identitätsbetrugs in Großbritannien.

Transparenz- und Berichtspflichten für den Online Safety Act 2023 und den Digital Services Act

Sowohl der Online Safety Act 2023 (OSA) als auch der Digital Services Act (DSA) verpflichten Plattformen zur Veröffentlichung jährlicher Transparenzberichte, wobei der erste Satz bis Juli 2025 fällig ist. Diese Berichte müssen Löschanfragen, Moderationsmetriken, Methoden zur Altersüberprüfung und umfassendere Maßnahmen zur Risikominderung abdecken.

Während sich das DSA auf die Reduzierung systemischer Risiken durch flexible, risikobasierte Verpflichtungen konzentriert, erzwingt das OSA eine strengere operative Einhaltung im Einklang mit Ofcom-geprüft Standards. Gemeinsam zielen die Gesetze darauf ab, die Rechenschaftspflicht zu stärken und die Sicherheit von Kindern auf digitalen Plattformen durch regelmäßige, überprüfbare Offenlegungen zu gewährleisten.

Illegale Inhalte und Plattformhaftung für den Online Safety Act 2023 und den Digital Services Act

Das OSA verpflichtet Plattformen dazu, proaktiv gegen illegale und schädliche Inhalte vorzugehen und bietet spezifische Pflichten zur Verhinderung illegaler Schäden. Die Vorschriften umfassen Geldbußen von bis zu 101 TP6T des weltweiten Umsatzes, Sperrverfügungen bei wiederholten Verstößen und priorisieren die Sicherheit von Kindern durch die Reduzierung von Inhalten rund um Selbstverletzung und CSAM sowie die Förderung oder Unterstützung schwerer Selbstverletzungen.

Es wird hervorgehoben, was nun als illegaler Inhalt und Straftat eingestuft wird. Durchsetzungsmaßnahmen werden eingeleitet, wenn ein erhebliches Risiko eines erheblichen Schadens für britische Nutzer besteht. Die DSA-Bestimmungen sehen Geldbußen von bis zu 6% des weltweiten Umsatzes, erfordert eine Verwaltung durch nationale Behörden unter Aufsicht der Europäischen Kommission (EK) und einen Schwerpunkt auf sehr große Online-Plattformen (VLOPs) und algorithmische Rechenschaftspflicht.

Fallstudie: TikTok unter DSA-Durchsetzung (2024)

Überblick

Im Februar 2024 leitete die Europäische Kommission eine Untersuchung gegen TikTok wegen mutmaßlicher Verstöße gegen den Digital Services Act (DSA) ein. Die Untersuchung konzentrierte sich auf Schlüsselbereiche wie Kinderschutz, Werbetransparenz, algorithmischen Datenzugriff und Risikomanagement im Zusammenhang mit potenziell suchterzeugendem Plattformdesign.

Ein besonderes Augenmerk galt der Wirksamkeit der Altersverifizierungssysteme von TikTok und der Frage, ob diese Minderjährige vor gefährlichen Inhalten schützen können. Auch die Struktur der Plattform und ihr Beitrag zu suchterzeugendem Nutzerverhalten wurden untersucht.

Aktionen und Antworten

Die Untersuchung der Europäischen Kommission zu TikTok konzentrierte sich auf drei kritische Bereiche: Kinderschutzmechanismen, Transparenz in der Werbepraxis und die Datenzugriffsrichtlinien der Plattform. Im Mittelpunkt der Untersuchung standen das algorithmische Design der TikTok-Systeme und ihre potenzielle Rolle bei der Förderung schädlichen Verhaltens, insbesondere bei Minderjährigen.

Auflösung

Bis August 2024 veröffentlichte die Kommission der Europäischen Union eine Pressemitteilung über die Zustimmung von TikTok Entfernen Sie die Belohnungsfunktion „TikTok Lite“. Diese Funktion war aufgrund ihres suchterzeugenden Designs, das die Benutzererfahrung von Kindern beeinträchtigte, in die Kritik geraten. Dieser Fall unterstreicht, dass die Durchsetzung des DSA nicht rein reaktiv ist. Regulierungsbehörden gestalten nun das Plattformdesign und schützen Grundrechte, insbesondere in kritischen Bereichen wie Jugendbeteiligung und algorithmischen Risiken.

Kontrollen für Werbung und Inhaltsprofilierung für Kinder im Internet

Der Digital Services Act (DSA) verbietet ausdrücklich die gezielte Ansprache Minderjähriger, einschließlich profilbasierter Werbung und der Verwendung von Dark-Pattern-Benutzeroberflächen in Content-Empfehlungssystemen. Diese neuen Regeln zielen darauf ab, manipulative Praktiken einzudämmen, die Kinder im Internet überproportional betreffen.

Der Online Safety Act 2023 (OSA) regelt zwar nicht direkt die gezielte Werbung, erlegt aber neue Verpflichtungen auf, um zu verhindern, dass Kinder, insbesondere in Suchmaschinen, auf schädliche kommerzielle Inhalte stoßen. Zusammen signalisieren diese Rahmenbedingungen eine strengere Regulierung der Verantwortung digitaler Plattformen gegenüber jungen Nutzern.

Mehr Kontrolle durch technische und ethische Umsetzungsstandards

Um sowohl dem Online Safety Act 2023 (OSA) als auch dem Digital Services Act (DSA) zu entsprechen, müssen Plattformen die Datenerfassung gemäß DSGVO minimieren, die Speicherung sensibler altersbezogener Informationen vermeiden und Transparenz bei ihren Altersverifizierungsprozessen gewährleisten. Sie müssen außerdem Schutzmaßnahmen gegen Reidentifizierungsrisiken implementieren und sichere Integrationsmethoden verwenden, wie z. B. SDKs oder No-Code-Module.

Die Plattform von ComplyCube unterstützt diese Anforderungen durch Geräteverifizierung, biometrische Lebenderkennung, NFC-Chip lesenund geräteübergreifende Erkennung, wodurch sowohl die Einhaltung von Vorschriften als auch eine anpassbare Implementierung im großen Maßstab gewährleistet wird.

Governance, Risikominderung und Verantwortung der Führungsebene

Sowohl der Online Safety Act 2023 (OSA) als auch der Digital Services Act (DSA) verpflichten Plattformen, regelmäßige Risikobewertungen durchzuführen und wesentliche Risiken für Nutzer, insbesondere Kinder, aktiv zu minimieren. Diese Bewertungen müssen sich mit der Exposition gegenüber Inhalten wie Pornografie, Selbstverletzung oder Essstörungen sowie mit systemischen Missbrauchsrisiken durch nutzergenerierte Inhalte befassen.

Darüber hinaus müssen Plattformen die Auswirkungen ihrer Werbe- und Empfehlungssysteme auf Minderjährige bewerten. Das OSA schreibt die Ernennung von Compliance-Beauftragten und die Führung revisionssicherer Aufzeichnungen vor, während das DSA robuste Richtlinien zur Inhaltsverwaltung und interne Audits für sehr große Online-Plattformen (VLOPs) vorschreibt.

Auswirkungen von OSA und DSA auf KMU und Nischenplattformen

Es ist ein weit verbreiteter Irrtum, dass kleinere Plattformen von regulatorischen Verpflichtungen ausgenommen sind. Tatsächlich gilt der Online Safety Act 2023 (OSA) aufgrund der Art des Inhaltsrisikos und der Zugänglichkeit, nicht aufgrund der Größe der Plattform. Der Digital Services Act (DSA) bietet zwar Verfahrenserleichterungen für kleine und mittlere Unternehmen (KMU) mit weniger als 50 Mitarbeitern oder einem Jahresumsatz von unter 10 Millionen Euro, entbindet sie aber nicht von ihren Kernpflichten. Alle Plattformen, unabhängig von ihrer Größe, sind verpflichtet, angemessene Sicherheitsmaßnahmen zu ergreifen, wenn ihre Dienste wahrscheinlich von Kindern genutzt werden.

Integration mit anderen neuen Datenschutzbestimmungen

Die Anforderungen an die Altersüberprüfung überschneiden sich mit mehreren wichtigen regulatorischen Rahmenbedingungen. Unter dem Datenschutz-Grundverordnung (DSGVO)Plattformen müssen Datenminimierung sicherstellen, eine Rechtsgrundlage für die Verarbeitung schaffen und die Grundsätze des „Privacy-by-Design“ anwenden. Die eIDAS-Verordnung legt Standards für die digitale Identitätssicherung fest, die insbesondere für EU-basierte Überprüfungen relevant sind.

Darüber hinaus Gesetz über digitale Märkte Gatekeeper-Plattformen werden einer genauen Prüfung hinsichtlich ihres Designs unterzogen, wobei auch altersbezogene Aspekte berücksichtigt werden. Sekundärgesetze im Rahmen des OSA und des DSA bieten detaillierte Schwellenwerte und Klassifizierungen, die zur Umsetzung dieser Verpflichtungen für verschiedene Dienstanbieter erforderlich sind.

Ofcom untersucht 34 Porno-Websites wegen fehlgeschlagener Altersüberprüfung

Untersuchung vorrangiger Inhalte

Am 31. Juli 2025 leitete Ofcom formelle Ermittlungen gegen vier digitale Dienstanbieter ein, die insgesamt 34 pornografische Websites betreiben. Diese Plattformen standen im Verdacht, gegen die OSA-Anforderungen zu verstoßen, da sie die neuen Regeln nicht umsetzten. Die Prüfung durch Ofcom konzentrierte sich darauf, ob die Plattformen Alterssicherungssysteme eingeführt hatten, die dem gesetzlich vorgeschriebenen „hochwirksamen“ Standard entsprachen.

Mögliche Strafen bei Nichteinhaltung

Das Ergebnis dieser Untersuchungen könnte entscheidende Präzedenzfälle für die künftige Regulierung ähnlicher Plattformen schaffen. Die Sanktionen können bis zu 18 Millionen Pfund oder 101 Billionen Pfund Sterling des weltweiten Umsatzes einer Plattform betragen, je nachdem, welcher Betrag höher ist. In extremen Fällen kann Ofcom Internetdienstanbieter auch anweisen, den Zugang zu den betreffenden Plattformen innerhalb Großbritanniens zu sperren.

Ergebnisse und Auswirkungen

Während die endgültigen Entscheidungen der laufenden Untersuchungen noch ausstehen, deuten erste Daten darauf hin, dass die Durchsetzung des OSA bereits messbare Auswirkungen hat. Große Plattformen für Inhalte für Erwachsene verzeichneten einen erheblichen Rückgang des Datenverkehrs. Ein Bericht berichtet von einem Rückgang der Besuche in Großbritannien um 471.000 Besucher nach der Einführung der neuen Regelung. Dieser starke Rückgang deutet darauf hin, dass Altersverifizierungssysteme aktiv eingeführt werden, entweder freiwillig oder aufgrund regulatorischen Drucks.

Einführung einer einheitlichen Compliance-Strategie

Um sowohl OSA als auch DSA einzuhalten, sollten Unternehmen eine ganzheitliche Compliance-Strategie verfolgen. Unternehmen müssen in dynamische Risikomanagementlösungen investieren, die automatisierte Workflows je nach Benutzerstandort oder Dokumenttyp auslösen können.

Die Optimierung der Test- und Iterationszyklen wird effizienter, wenn man mit einem Anbieter für Altersüberprüfung Mit SDKs und APIs für eine nahtlose Integration. Darüber hinaus kann die Überwachung sich entwickelnder Verhaltenskodizes Unternehmen dabei unterstützen, mit den sich ändernden Vorschriften Schritt zu halten. Weitere Informationen finden Sie hier: Was sind Lösungen zur Identitätsüberprüfung?

Die wichtigsten Erkenntnisse

- Das Online-Sicherheitsgesetz schreibt strenge Alterskontrollen und Sicherheitsprotokolle zum Schutz von Kindern vor.

- Der EU-Digital Services Act wendet einen angemessenen, risikobasierten Ansatz an, der auf die Plattform zugeschnitten ist.

- Sowohl das britische OSA als auch das DSA der EU überträgt den Unternehmen größere Verantwortung bei der Regulierung von Inhalten.

- Kleinere Dienste, einschließlich Startups, sind nicht von der Prüfung gemäß OSA und DSA ausgenommen.

- Plattformen müssen eine ethische Alterssicherung einführen die Grundrechte anerkennen, ein datenschutzfreundliches Design und einheitliche Compliance-Tools.

Verbessern Sie die Einhaltung der Altersüberprüfungsvorschriften weltweit

Die Konvergenz des Online Safety Act 2023 (OSA) und des Digital Service Act (DSA) spiegelt eine Verschiebung der digitalen Verantwortung wider. Plattformen müssen über reaktive Moderation hinausgehen und Sicherheitsprinzipien einführen, insbesondere für Kinder. Unternehmen, die offene, nutzerorientierte Sicherheitspraktiken anbieten, werden in einer sich verändernden Compliance-Landschaft Vertrauen und regulatorisches Wohlwollen gewinnen.

Entdecken Sie nahtlose und maßgeschneiderte mehrschichtige Alterssicherungslösungen auf der ComplyCube-Plattform. Onboarding von Kunden in Sekundenschnelle und Vermeidung von massiven Durchsetzungsmaßnahmen gemäß dem Online Safety Act und dem Digital Services Act. Sprechen Sie mit einem Mitglied der ComplyCube Team heute.

Häufig gestellte Fragen

Gelten OSA und DSA für Plattformen mit überwiegend erwachsenem Publikum?

Auch wenn sich eine Plattform an Erwachsene richtet, muss sie die Vorschriften einhalten, wenn Minderjährige darauf zugreifen können. Dies gilt insbesondere in sozialen Medien, wo Inhalte von verschiedenen Altersgruppen geteilt werden. Plattformen müssen angemessene Maßnahmen ergreifen, beispielsweise Inhaltsfilter und Kindersicherungen, um zu verhindern, dass Minderjährige schädlichen oder nicht jugendfreien Inhalten ausgesetzt werden.

Was gilt gemäß dem Online Safety Act (OSA) als Inhalt mit höchster Priorität?

Zu den vorrangigen Inhalten zählen Pornografie sowie Material, das Essstörungen, Selbstverletzung oder Selbstmord fördert. Dies gilt auch dann, wenn die Inhalte legal sind, da sie als schädlich für Kinder gelten.

Welchen Einfluss haben OSA oder DSA auf die Altersüberprüfung auf Social-Media-Plattformen?

Gemäß dem OSA ist eine Altersüberprüfung obligatorisch, wenn Kinder wahrscheinlich auf die Plattform zugreifen. Das EU-DSA verlangt zudem eine Alterssicherung, wenn Inhalte Risiken bergen. Das bedeutet, dass die meisten gängigen Social-Media-Plattformen Maßnahmen zur Altersüberprüfung ergreifen müssen.

Können Unternehmen oder Führungskräfte aufgrund dieser Gesetze strafrechtlich belangt werden?

Das OSA sieht vor, dass Führungskräfte strafrechtlich zur Verantwortung gezogen werden, wenn Plattformen ihren Pflichten zur Sicherheit und Altersüberprüfung nicht nachkommen. Das DSA sieht zudem Strafen vor, darunter auch strafrechtliche Konsequenzen, je nachdem, wie die einzelnen EU-Mitgliedsstaaten die Verordnung umsetzen.

Wie schützen OSA und DSA die Grundrechte und setzen gleichzeitig deren Einhaltung durch?

Beide Gesetze enthalten Schutzmaßnahmen, um Regulierung und Nutzerrechte in Einklang zu bringen. Sie verpflichten Plattformen, die Meinungsfreiheit und Privatsphäre zu respektieren und gleichzeitig angemessene Altersüberprüfungs-, Inhaltsmoderations- und Meldepflichten anzuwenden.