Kurz gesagt: Tools zur Deepfake-Erkennung Sie sind für FinTechs unerlässlich, um Identitätsbetrug mit synthetischen Identitäten wirksam zu bekämpfen, indem sie manipulierte Medien in digitalen Onboarding-Prozessen erkennen. Der Schutz vor Deepfake-Bedrohungen ist entscheidend für die Wahrung der Integrität. Zweifellos., Deepfake-Erkennungstools ab 2026 entwickeln sich weiter, aber Welche Einschränkungen weisen die aktuellen Deepfake-Erkennungswerkzeuge auf??

Was sind Deepfake-Erkennungstools und wie funktionieren sie?

Software und Tools zur Erkennung von Deepfakes dienen der Identifizierung und Analyse manipulierter oder synthetischer Medien. Beispiele hierfür sind Videos, Bilder und Audiodateien, die mithilfe künstlicher Intelligenz (KI) generiert wurden. Diese werden missbraucht, um sich als legitime Nutzer auszugeben. Dies verursacht erhebliche finanzielle und rufschädigende Folgen. Solche Systeme nutzen eine Kombination aus KI-Tools, Computer Vision und Mustererkennung, um authentische Inhalte von Fälschungen zu unterscheiden.

Viele Deepfake-Detektoren liefern Werte, die die Wahrscheinlichkeit einer Manipulation von Medieninhalten durch Dritte anzeigen. Einige Tools verwenden ein binäres Klassifizierungssystem, um die Bildintegrität zu beurteilen und so eindeutige Ergebnisse für die Entscheidungsfindung zu liefern. Dies ermöglicht es Risikobewertungssystemen, differenzierte Entscheidungen zu treffen, wie z. B. den Zugriff zu gewähren, eine zusätzliche Überprüfung anzufordern oder die Inhalte zur manuellen Prüfung zu kennzeichnen.

Moderne Systeme vergleichen Eingabedaten mit umfangreichen Datensätzen bekannter realer und synthetischer Beispiele. Da Deepfake-Ersteller immer ausgefeiltere generative Modelle verwenden, müssen sich auch die Erkennungsmodelle kontinuierlich weiterentwickeln. Sie müssen subtile Unstimmigkeiten aufspüren, die dem menschlichen Auge verborgen bleiben. Fortschrittliche Erkennungsmodelle mit schnellerer Analyse untersuchen biologische Signale, wie beispielsweise geringfügige Veränderungen des Blutflusses, um reale von synthetischen Medien zu unterscheiden.

Die Klassifizierung auf Frame-Ebene dient auch der Analyse einzelner Videobilder auf Manipulationsanzeichen. Deepfake-Erkennungstools nutzen maschinelles Lernen, Computer Vision und biometrische Analysen, um KI-generierte Täuschungen aufzudecken. Beispielsweise verwenden einige Lösungen Computer Vision, um durch die Durchblutung verursachte Mikrovariationen der Hautfarbe zu erkennen, die in synthetischen Medien weitgehend fehlen.

Identitätsrisiko im digitalen Finanzwesen

FinTechs agieren in einer digitalen Welt, in der Kunden nur noch selten persönlich erscheinen. Dieser Komfort hat jedoch Folgendes geschaffen: neue Betrugsmöglichkeiten, Insbesondere durch synthetische Identitäten, die aus gestohlenen und gefälschten Daten erstellt werden. Deepfake-Technologie ermöglicht es Kriminellen, überzeugende, aber gefälschte Bilder, Videos und Sprachaufnahmen zu erstellen, die echte Personen imitieren.

Darüber hinaus können diese Manipulationsformen herkömmliche Identitätsprüfungssysteme umgehen. Dies kann für FinTechs erhebliche finanzielle Verluste und Compliance-Risiken verursachen. Deepfakes werden zunehmend bei Phishing-Angriffen und BEC-Betrug (Business Email Compromise) eingesetzt, bei dem Angreifer sich als Führungskräfte ausgeben, um betrügerische Transaktionen zu autorisieren.

IIn diesem Umfeld sind Deepfake-Erkennungstools unerlässlich. Diese Systeme analysieren digitale Medien auf Manipulationen und tragen dazu bei, die Echtheit, Authentizität und Autorisierung der Person am anderen Ende einer Transaktion oder eines Onboarding-Prozesses sicherzustellen. FinTechs müssen Unternehmen vor Identitätsbetrug und Reputationsschäden schützen, insbesondere da bereits 461.000 Unternehmen Opfer von Deepfake-basiertem Identitätsbetrug geworden sind.

Warum Deepfake-Erkennungstools für FinTechs wichtig sind

FinTech-Plattformen führen jährlich Millionen von Identitätsprüfungen per Fernzugriff für Kontoeröffnungen, Kreditvergabe, Zahlungen und Compliance-Anforderungen durch. Betrugsversuche beinhalten in diesem Zusammenhang häufig Identitätsdiebstahl, bei dem Angreifer gestohlene persönliche Daten mit KI-generierten Medien kombinieren. Deepfake-Inhalte und digitale Manipulationen werden immer ausgefeilter, was es traditionellen Systemen erschwert, Betrug aufzudecken.

Jetzt, Deepfake Videoaufnahmen stellen insbesondere bei der Online-Einarbeitung eine erhebliche Schwachstelle dar. Betrüger können manipulierte Videos einreichen, die der angegebenen Identität zu entsprechen scheinen, und so einfache Selfie-Verifizierungssysteme täuschen. Ohne zuverlässige Erkennungsmechanismen führen diese Angriffe zu unberechtigtem Zugriff, finanziellen Verlusten und behördlichen Ermittlungen.

Tools zur Erkennung von Deepfakes arbeiten Hand in Hand mit biometrischen Analysen (z. B. Lebenderkennung, Gesichtserkennung) und Dokumentenauthentifizierung. Dieser mehrstufige Ansatz hilft, legitime Bewerber von Betrügern zu unterscheiden und das Vertrauen in digitale Onboarding-Prozesse zu stärken. Die Echtzeit-Deepfake-Erkennung kann synthetische Stimmen und Videos in digitalen Inhalten kennzeichnen und so finanzielle Schäden durch Deepfake-basierte Cyberkriminalität verhindern.

Wie Deepfake-Detektoren in die FinTech-Verifizierung passen

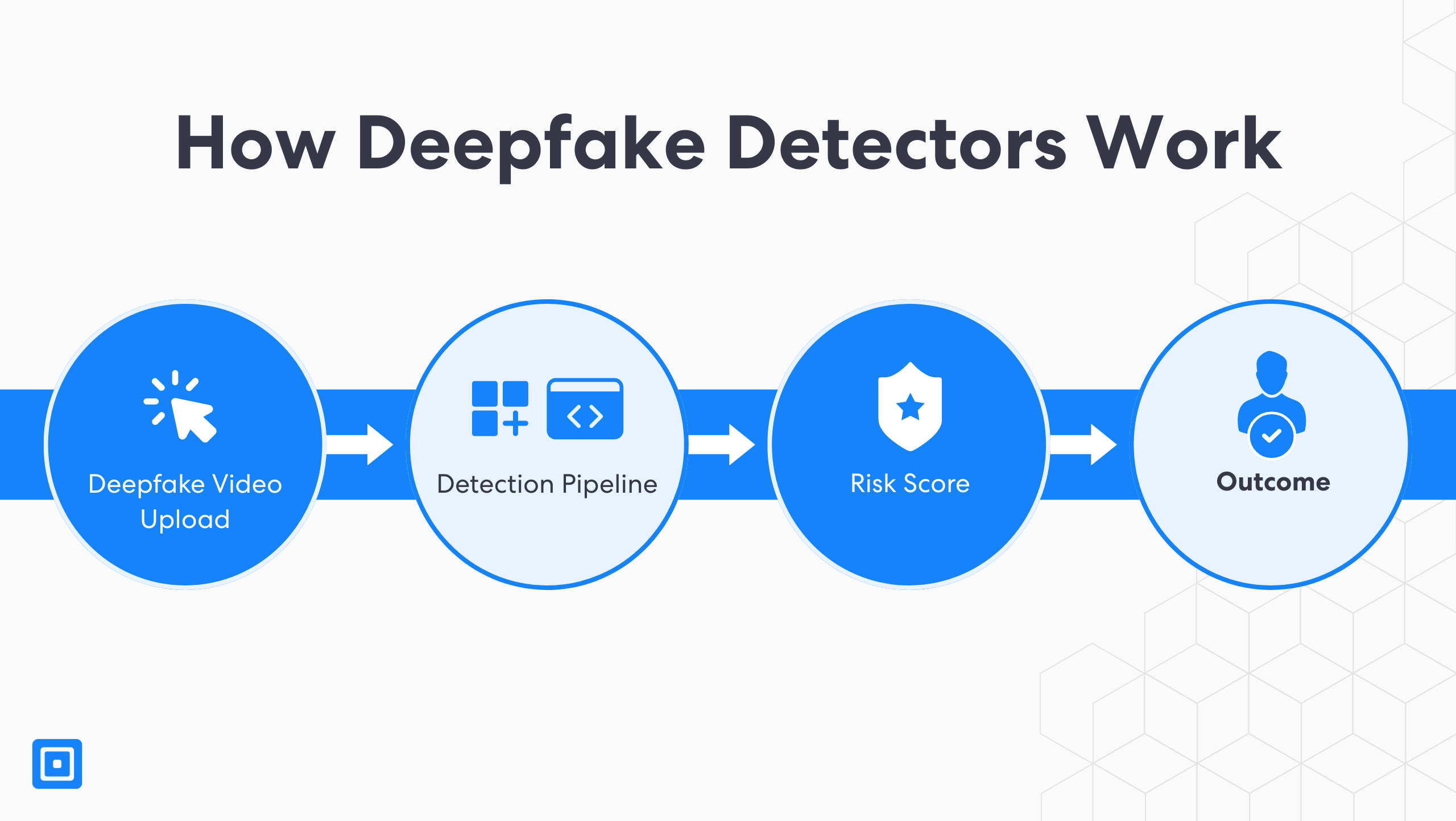

Die nahtlose Integration von Deepfake-Erkennungssoftware in Kennen Sie Ihren Kunden (KYC) und Bekämpfung der Geldwäsche (AML) Workflows werden über API-Zugriff und -Bereitstellung gesteuert. Wenn ein Benutzer während des Onboardings ein Video hochlädt, initiiert das System eine Erkennungspipeline, die sich auf die Echtzeit-Erkennung von Deepfakes konzentriert und Gesichtsbewegungen, Texturanomalien, Blinzelmuster und Frame-Übergänge analysiert, um Anzeichen für Deepfake-Inhalte zu identifizieren.

Das System generiert anschließend einen Risikowert für digitale Inhalte, der die Wahrscheinlichkeit einer künstlichen Manipulation widerspiegelt. Dieser Wert fließt in bestehende Entscheidungsmechanismen ein und löst automatisierte Reaktionen aus, wie z. B. Genehmigung, Ablehnung oder zusätzliche Überprüfung. Neben visuellen Hinweisen werten diese Schlüsselfunktionen von Tools auch Metadaten und Verhaltenssignale wie Geräte-Fingerprinting oder Nutzerinteraktionsmuster aus. Diese mehrstufige Prüfung stärkt die Integrität des digitalen Onboardings und hilft Fintech-Unternehmen, Bedrohungen durch synthetische Identitäten einen Schritt voraus zu sein.

In Umgebungen mit hohem Datenaufkommen ist die Echtzeit-Erkennung von Deepfakes unerlässlich. Anders als ältere Systeme, beispielsweise in Regierungsbehörden, die mit Live-Video oder HD-Inhalten Schwierigkeiten haben, sind moderne Lösungen für Fintechs auf Leistung und Skalierbarkeit ausgelegt und gewährleisten schnelle, präzise Ergebnisse über Web- und Mobilkanäle. Zu den wichtigsten Funktionen gehören Integritätsprüfungen der Medien, Analysen mit geringer Latenz und die vollständige Integration in die Infrastruktur für Unternehmensrisikomanagement und Compliance.

Erkennungsgenauigkeit von Deepfake-Erstellern

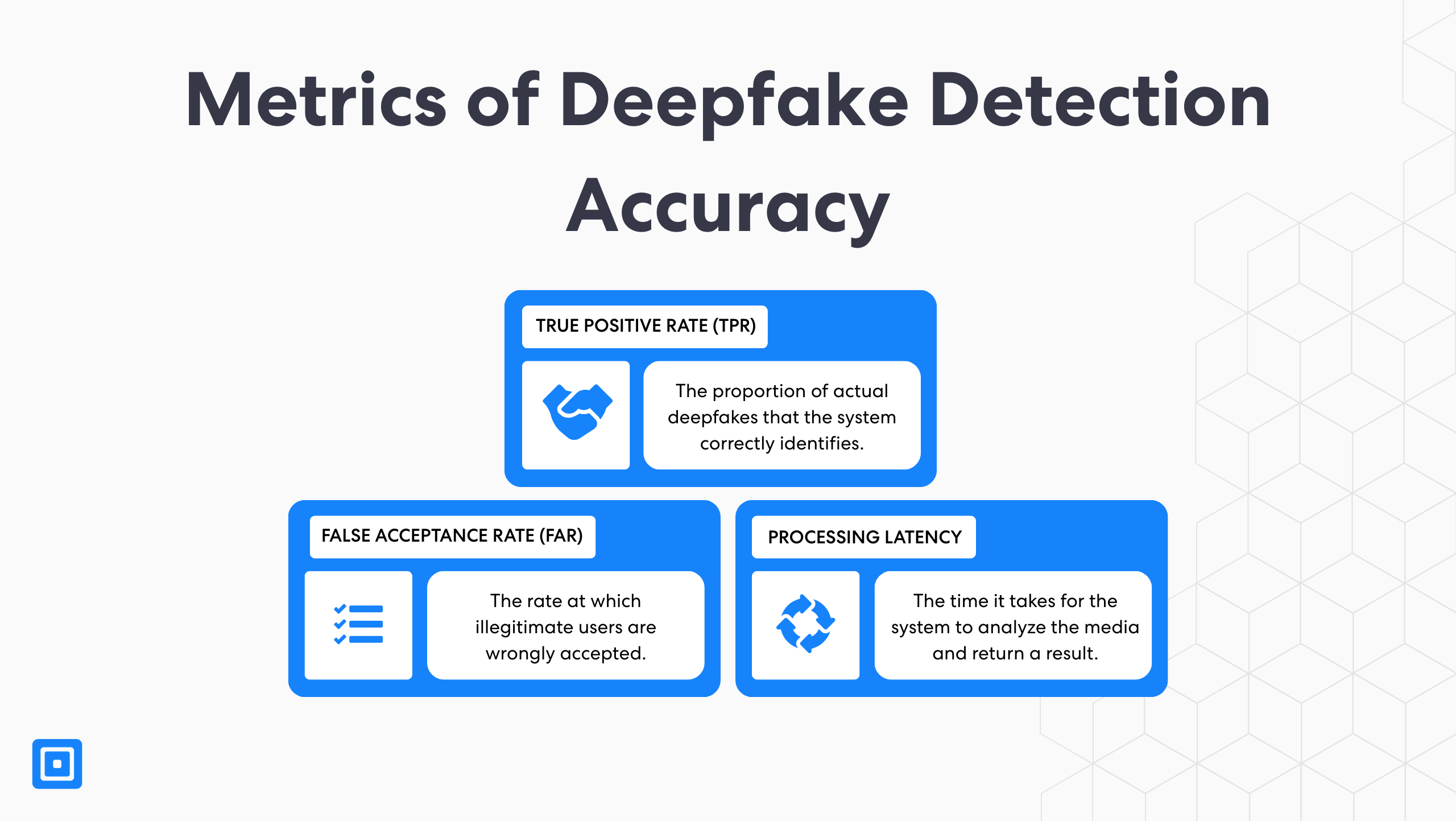

Die Erkennungsgenauigkeit ist ein zentrales Kriterium zur Bewertung von Deepfake-Erkennungslösungen. Sie basiert auf drei Schlüsselindikatoren: der Trefferquote (TPR), der Falschakzeptanzrate (FAR) und der Verarbeitungslatenz. Die TPR misst den Anteil der echten Deepfakes, die das System korrekt identifiziert. Die FAR hingegen gibt an, wie häufig ein biometrisches System fälschlicherweise einer nicht autorisierten Person Zugriff gewährt. Die Verarbeitungslatenz bezeichnet schließlich die Zeit, die das System benötigt, um die Medien zu analysieren und ein Ergebnis zu liefern.

Um wettbewerbsfähig zu bleiben, sollten FinTechs ihre Erkennungstools unter verschiedenen Bedingungen testen, darunter unterschiedliche Lichtverhältnisse, Hintergründe, Geräte und demografische Gruppen, um eine faire und zuverlässige Leistung zu gewährleisten. Videoauflösung und Komprimierungsstufen haben einen erheblichen Einfluss auf die Genauigkeit der Echtzeit-Erkennung. Teams sollten die Tools daher mit verschiedenen Videoqualitäten und Komprimierungseinstellungen evaluieren, um ihre Robustheit in realen Anwendungsszenarien zu bestätigen.

Daher variiert die Erkennungsleistung häufig je nach Hautton und demografischer Gruppe. Demografische und kulturelle Verzerrungen Fehler in den Trainingsdaten können die Effektivität von Deepfake-Erkennungstools beeinträchtigen, was zu einer geringeren Genauigkeit für bestimmte Nutzer und einer reduzierten Zuverlässigkeit insgesamt führt. FinTechs sollten Lösungen priorisieren, die unter verschiedenen realen Bedingungen eine hohe Leistungsfähigkeit aufweisen.

Kommerzielle Deepfake-Erkennungstools und der Markt

Kommerzielle Tools bieten häufig Lösungen für Unternehmen mit Skalierbarkeit, hoher Erkennungsgenauigkeit und Integrationsmöglichkeiten. Sie sind Open-Source-Modellen oft in Bezug auf Support, Zuverlässigkeit und regelmäßige Updates überlegen. Open-Source-Tools bieten zwar mehr Transparenz und Anpassungsmöglichkeiten, jedoch auf Kosten geringerer Erkennungsfähigkeiten und eines höheren Wartungsaufwands.

Für Finanzdienstleistungen entwickelte Deepfake-Detektoren verarbeiten große Datenmengen, liefern Konfidenzwerte und lassen sich nahtlos in Risikomanagement- und Fallbearbeitungssysteme integrieren. Open-Source-Erkennungsalgorithmen, kombiniert mit hybriden Ansätzen und kommerziellem Support, schaffen ein ausgewogenes Verhältnis zwischen Transparenz und professioneller Zuverlässigkeit. Dadurch bieten diese Tools umfassende und skalierbare Lösungen für Organisationen, die komplexe Prozesse zur Identitätsprüfung verwalten.

Es ist wichtig, realistische Erwartungen zu haben. Selbst die besten kommerziellen Tools können in der Praxis im Vergleich zu kontrollierten Testumgebungen eine geringere Genauigkeit aufweisen. Die Erkennungsgenauigkeit hängt von der Qualität und Vielfalt der Trainingsdaten ab, da begrenzte oder nicht repräsentative Datensätze Schwachstellen schaffen. Unternehmen sollten kontinuierliche Verbesserungsprozesse mit regelmäßigen Audits und Aktualisierungen etablieren, um die Wirksamkeit der Erkennung sicherzustellen. Ein effektiver Einsatz erfordert die Kombination von Erkennungstools mit umfassenderen Risikosignalen und betrieblichen Kontrollen.

Was sind die aktuellen Einschränkungen von Deepfake-Erkennungswerkzeugen?

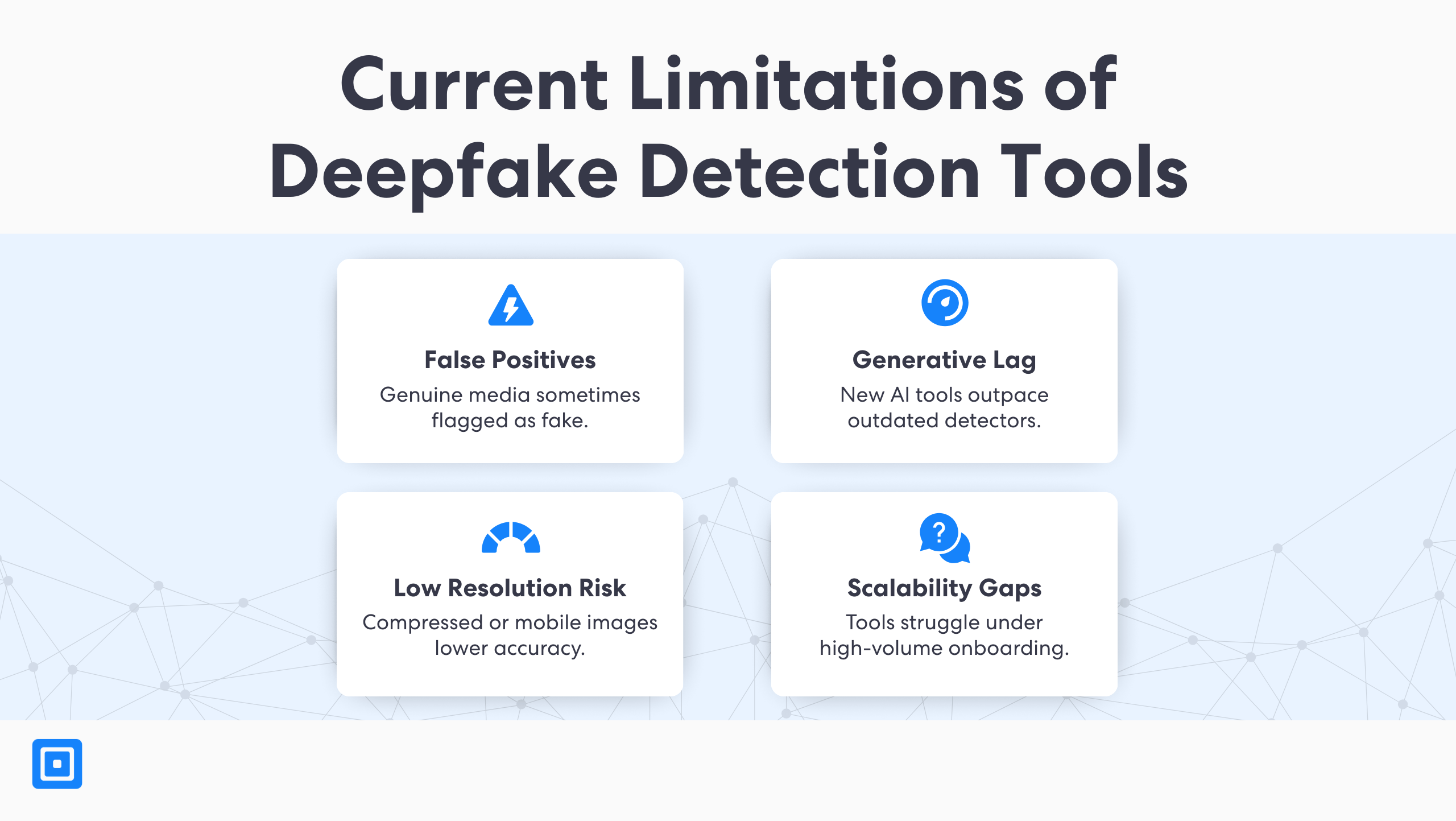

Trotz der jüngsten Fortschritte jedoch, aktuelle Einschränkungen bei der Erkennung von Deepfakes Die Erkennungsmodelle haben Schwierigkeiten mit minderwertigen oder stark komprimierten Medien, da diese visuelle Merkmale verdecken können, die für eine genaue Analyse unerlässlich sind. Sie erkennen möglicherweise keine hochwertigen Deepfakes, die mit fortschrittlichen Methoden erzeugt wurden. Zudem hinken einige Systeme den neuesten Entwicklungen im Bereich der generativen KI hinterher. Selbst bei authentischen Inhalten können bestimmte Tools diese falsch klassifizieren, was zu Fehlalarmen führt und Onboarding-Prozesse stören kann.

Viele Deepfake-Erkennungstools haben zudem Schwierigkeiten mit der Echtzeitanalyse. Dies tritt insbesondere bei Live-Videoanrufen auf, da sie nicht pausieren können, um Unstimmigkeiten zu untersuchen. FinTechs benötigen daher Ausweichmöglichkeiten wie manuelle Überprüfung oder gestaffelte Verifizierung, wenn die Vertrauenswerte in unklare Bereiche fallen. Prüfprotokolle und nachvollziehbare Bewertungskriterien sind außerdem wichtig für die Einhaltung von Vorschriften und die Berichterstattung an Aufsichtsbehörden.

Die Rolle von KI-gestützten Deepfake-Erkennungstools in der laufenden Verteidigung

KI-Tools ermöglichen sowohl die Erstellung als auch die Erkennung von Deepfakes. Die Landschaft der Deepfake-Erkennung entwickelt sich rasant. Angesichts ständig neuer Tools und Techniken ist es für Organisationen und Behörden unerlässlich, neuen Bedrohungen einen Schritt voraus zu sein. Da generative KI immer realistischere Betrugsversuche erzeugt, müssen Fintechs auf verbesserte, anpassungsfähige Systeme für maschinelles Lernen setzen. Erfahren Sie hier mehr über die Erkennung KI-generierter Deepfakes: Deepfake-Erkennung für die moderne Medienbedrohung.

Um den Bedrohungen durch generative KI einen Schritt voraus zu sein, müssen Systeme eingesetzt werden, die Deepfakes nicht nur heute erkennen, sondern auch morgen aus jedem neuen Versuch lernen.

Gemäß Harry Varatharasan, “Um generativen KI-Bedrohungen einen Schritt voraus zu sein, müssen Systeme eingesetzt werden, die Deepfakes nicht nur heute erkennen, sondern auch aus jedem neuen Versuch von morgen lernen”, so der Chief Product Officer von ComplyCube. Der Ansatz von ComplyCube konzentriert sich auf kontinuierliches Modelltraining und den Austausch von Informationen, um die Abwehr anpassungsfähig und reaktionsschnell zu halten.“

Führende Erkennungsplattformen nutzen kontinuierliches Training, adversarielles Lernen und föderierte Aktualisierungen aus branchenübergreifenden Bedrohungsdaten. Automatisierte Warnmeldungen und Echtzeitüberwachung sind unerlässlich, um Bedrohungen frühzeitig zu erkennen und darauf zu reagieren. Diese Funktionen tragen dazu bei, die Erkennungsrelevanz aufrechtzuerhalten und die Abwehr gegen sich ständig weiterentwickelnde Manipulationstechniken zu verbessern. Angreifer setzen zunehmend generative KI-Deepfakes ein, um die öffentliche Wahrnehmung zu manipulieren und ihre Angriffe zu verstärken.

Deepfakes in Live-Streams erkennen

Echtzeit-Deepfake-Erkennung Digitales Onboarding ist heute für Unternehmen unerlässlich. Fortschrittliche KI-Tools überwachen Gesichtsbewegungen, Mimik und zeitliche Signale, um echte Nutzer von manipulierten Beiträgen zu unterscheiden. Die multimodale Erkennung, die Audio-, Video- und Metadatenströme analysiert, verbessert die Genauigkeit in Live-Streams zusätzlich.

Tatsächlich ist die Integration der Deepfake-Analyse in Arbeitsabläufe mit Live-Videoanrufen oder sofortigen Selfie-Prüfungen unerlässlich. Sie ermöglicht einen reibungslosen Betrieb ohne Beeinträchtigung der Benutzerfreundlichkeit. Die Verhaltensanalyse ergänzt die automatisierte Erkennung, indem sie Sicherheitsteams hilft, mehrdeutige Ergebnisse zu interpretieren und verdächtige Aktivitäten zu identifizieren. In Kombination mit Dokumentenprüfung und Geräteinformationen verbessert die Deepfake-Erkennung die Onboarding-Sicherheit ganzheitlich.

Fallstudie: Expansion der Hongkonger Neobank und Deepfake-Videos

Deepfake-Videobetrug und gefälschte Identitätsprüfung

Mitte 2025, in Hongkong ansässige Digitalbank Im Zuge einer regionalen Expansionskampagne kam es zu einer koordinierten Betrugskampagne. Betrüger nutzten KI-generierte Deepfake-Videos, um gefälschte Identitätsnachweise einzureichen. Zweifellos ahmten sie dabei Gesichtsbewegungen und Sprache nach.

Mehrschichtige Betrugsprävention mit Deepfake-Erkennungstools

Infolgedessen integrierte die Bank ein mehrstufiges Betrugspräventionssystem, dessen Kernstück eine spezialisierte Engine zur Erkennung von Deepfakes bildet. Das Team setzte Verhaltensanalysen ein, um ungewöhnliche Interaktionen zwischen Nutzern und Geräten zu erkennen und wiederverwendete Zugangspunkte zu blockieren, die mit früheren Betrugsfällen in Verbindung standen.

Integration der Deepfake-Erkennung in digitale Onboarding-Prozesse

- Über 50 betrügerische Kontoanträge wurden im ersten Monat nach der Einführung blockiert.

- 90% markierte Fälle, die als versuchte Identitätsbetrugsversuche verifiziert wurden.

- Die automatisierte Entscheidungszeit wurde durch 35% verbessert, wodurch Verzögerungen beim Onboarding reduziert werden.

Compliance und regulatorische Auswirkungen

Regulatorische Erwartungen im Rahmen von Rahmenbedingungen wie dem Task Force Finanzielle Maßnahmen (FATF) Empfehlungen und EU-Richtlinien wie z. B. AMLD6 Fintechs müssen robuste Systeme zur Identitätsprüfung und Risikobewertung implementieren. Angesichts der zunehmenden Verbreitung von Identitätsbetrug hängt die Einhaltung dieser Standards immer stärker von der Fähigkeit ab, manipulierte biometrische und mediale Daten zu erkennen und abzulehnen.

Deepfake-Erkennungstools spielen jedoch ab 2026 eine entscheidende Rolle bei der Erfüllung dieser Verpflichtungen. Um die Zuverlässigkeit von KYC-Prozessen zu verbessern und interne Kontrollen zu stärken, müssen Unternehmen die Authentizität nutzergenerierter Inhalte überprüfen. Gut validierte Systeme verbessern zudem die Auditbereitschaft und liefern den Aufsichtsbehörden eindeutige Nachweise für die Einhaltung der Vorschriften.

Geschäftliche Auswirkungen von Deepfake-Erkennungstools

Investitionen in Deepfake-Technologie Sie erzielen einen hohen ROI durch die Reduzierung von Betrugsverlusten, die Minimierung manueller Prüfungen und die Steigerung der betrieblichen Effizienz. Vor allem aber senken diese Deepfake-Erkennungstools, wenn sie direkt in Onboarding-Prozesse integriert werden, die Kundenabbruchraten und verbessern die Gesamtkonversionsrate.

Doch neben den unmittelbaren Kosteneinsparungen stärken umfassende Erkennungssysteme das langfristige Vertrauen. Sie verbessern die Markenreputation, insbesondere in Märkten mit erhöhtem Risiko für digitalen Betrug. Indem sie die Authentizität nutzergenerierter Inhalte schützen, tragen sie zum Schutz digitaler Ökosysteme bei und wahren die Glaubwürdigkeit der Medien angesichts immer realistischerer Manipulationen.

Die wichtigsten Erkenntnisse

- Tools zur Deepfake-Erkennung sind entscheidend für die Abwehr von Identitätsdiebstahl mit synthetischen Identitäten.

- Erkennungsgenauigkeit hat direkte Auswirkungen auf das Risiko und die Benutzererfahrung.

- Kommerzielle Werkzeuge Bereitstellung skalierbarer, unternehmenstauglicher Lösungen für FinTechs.

- Die Grenzen verstehen Die derzeitigen Deepfake-Erkennungswerkzeuge bilden mehrschichtige Verteidigungssysteme.

- Tools zur Deepfake-Erkennung Sie werden sich auch 2026 weiterentwickeln und adaptive Strategien mit mehreren Signalen erfordern.

Warum FinTechs mit ComplyCube zusammenarbeiten sollten

Zusammenfassend bietet ComplyCube eine zuverlässige und skalierbare Betrugsprävention mit Deepfake-Erkennung als Kernfunktion. Die API-basierte Plattform unterstützt fortschrittliche biometrische Prüfungen, die Einhaltung regulatorischer Vorgaben und ein reibungsloses Onboarding. Ob Markteintritt oder die Verschärfung von Kontrollen – mit ComplyCube können FinTechs sicher agieren. Sprechen Sie mit einem Mitglied des ComplyCube-Teams. um maßgeschneiderte Lösungen zur Erkennung von Deepfakes und zur Minderung des Risikos synthetischer Betrugs zu erforschen.

Häufig gestellte Fragen

Welche Deepfake-Erkennungstools werden im FinTech-Bereich eingesetzt?

Deepfake-Erkennungstools werden ab 2026 manipulierte Medien in nutzergenerierten Dokumenten, Selfies und Videos identifizieren. Sie helfen, Betrug bei der Registrierung und im KYC-Prozess (Know Your Customer) zu verhindern. Darüber hinaus werden Deepfake-Erkennungstools eingesetzt, um synthetische Medien zu erkennen und die digitale Forensik bei der Überprüfung der Authentizität nutzergenerierter Inhalte zu unterstützen. Dies ist entscheidend im Kampf gegen Desinformation und für den Schutz des öffentlichen Vertrauens.

Wie genau sind kommerzielle Deepfake-Erkennungstools heutzutage?

Führende Tools erreichen in Laborumgebungen eine Genauigkeit von über 90% und unterstützen Echtzeitanalysen. Zu den wichtigsten Funktionen führender Deepfake-Erkennungstools gehören mehrschichtige Erkennung, forensische Berichte mit Konfidenzwerten und Heatmaps sowie die Unterstützung der Audio-Deepfake-Erkennung zur Identifizierung KI-generierter Stimmen und Stimmklonierung.

Welche Einschränkungen weisen die derzeitigen Deepfake-Erkennungswerkzeuge auf?

Aktuelle Deepfake-Erkennungstools stoßen bei schlechter Videoqualität oder neuen Generierungstechniken an ihre Grenzen. Hintergrundgeräusche und die von Social-Media-Plattformen verwendeten Komprimierungsalgorithmen können die Erkennungsgenauigkeit zusätzlich beeinträchtigen. Da Fehlalarme möglich sind, sind mehrstufige Risikoprüfungen unerlässlich. Erkennungstools, die biologische Signale analysieren, zeigen in realen Szenarien tendenziell bessere Ergebnisse als solche, die sich ausschließlich auf visuelle Artefakte stützen. Viele Deepfake-Erkennungstools haben zudem Schwierigkeiten mit der Echtzeitanalyse, insbesondere während Live-Videoanrufen, da sie nicht pausieren können, um Unstimmigkeiten zu untersuchen.

Ist die Erkennung von Deepfakes für die Einhaltung gesetzlicher Vorschriften zwingend erforderlich?

Obwohl die Echtzeit-Erkennung von Deepfakes in den meisten regulatorischen Rahmenwerken nicht explizit vorgeschrieben ist, spielt sie eine entscheidende Rolle bei der Erfüllung umfassender Compliance-Anforderungen. Aufsichtsbehörden wie die Financial Action Task Force (FATF) und die EU im Rahmen von eIDAS betonen die Notwendigkeit einer gründlichen Identitätsprüfung, der Authentizität von Medien und risikobasierter Kontrollen. Die Deepfake-Erkennung trägt zu diesen Prinzipien bei, indem sie die Integrität biometrischer und Video-Eingaben überprüft, das Risiko von Identitätsdiebstahl reduziert und das digitale Onboarding verbessert. Für FinTechs, die in Hochrisiko- oder grenzüberschreitenden Umgebungen tätig sind, demonstriert die Implementierung solcher Tools proaktive Compliance und verbessert die Auditbereitschaft.

Wie kann ComplyCube die Erkennung von Deepfakes im FinTech-Bereich unterstützen?

ComplyCube integriert die Erkennung von Betrugsversuchen in seine Identitätsverifizierungssuite und kombiniert sie mit Lebendigkeitsprüfungen, Dokumentenvalidierung und PEP-/Sanktionsprüfungen, um einen umfassenden Schutz vor Betrug zu bieten. Die Plattform unterstützt forensische Analysen und die Erkennung von Stimmklonierung als Teil ihrer umfassenden Betrugsschutzsuite und hilft so, die Authentizität digitaler Medien und Audiodateien zu untersuchen und zu verifizieren. Die Authentizität digitaler Inhalte ist von höchster Bedeutung, und diese Tools helfen, Anzeichen von Manipulation, einschließlich KI-generierter Bilder, zu erkennen. Ab 2026 analysieren effektive Deepfake-Erkennungstools unsichtbare biologische Signale und komplexe medienübergreifende Muster, um synthetische Medien zu entlarven. Deepfake-Technologie wird auch zur Erkennung und Prävention von BEC-Angriffen für alle eingesetzt, von Regierungsbehörden bis hin zu Fintechs.